홈페이지에서 에세스 허용받기

홈페이지에 가서 Download the Model을 누른다.

Llama 2 - Meta AI

We have a broad range of supporters around the world who believe in our open approach to today’s AI — companies that have given early feedback and are excited to build with Llama 2, cloud providers that will include the model as part of their offering

ai.meta.com

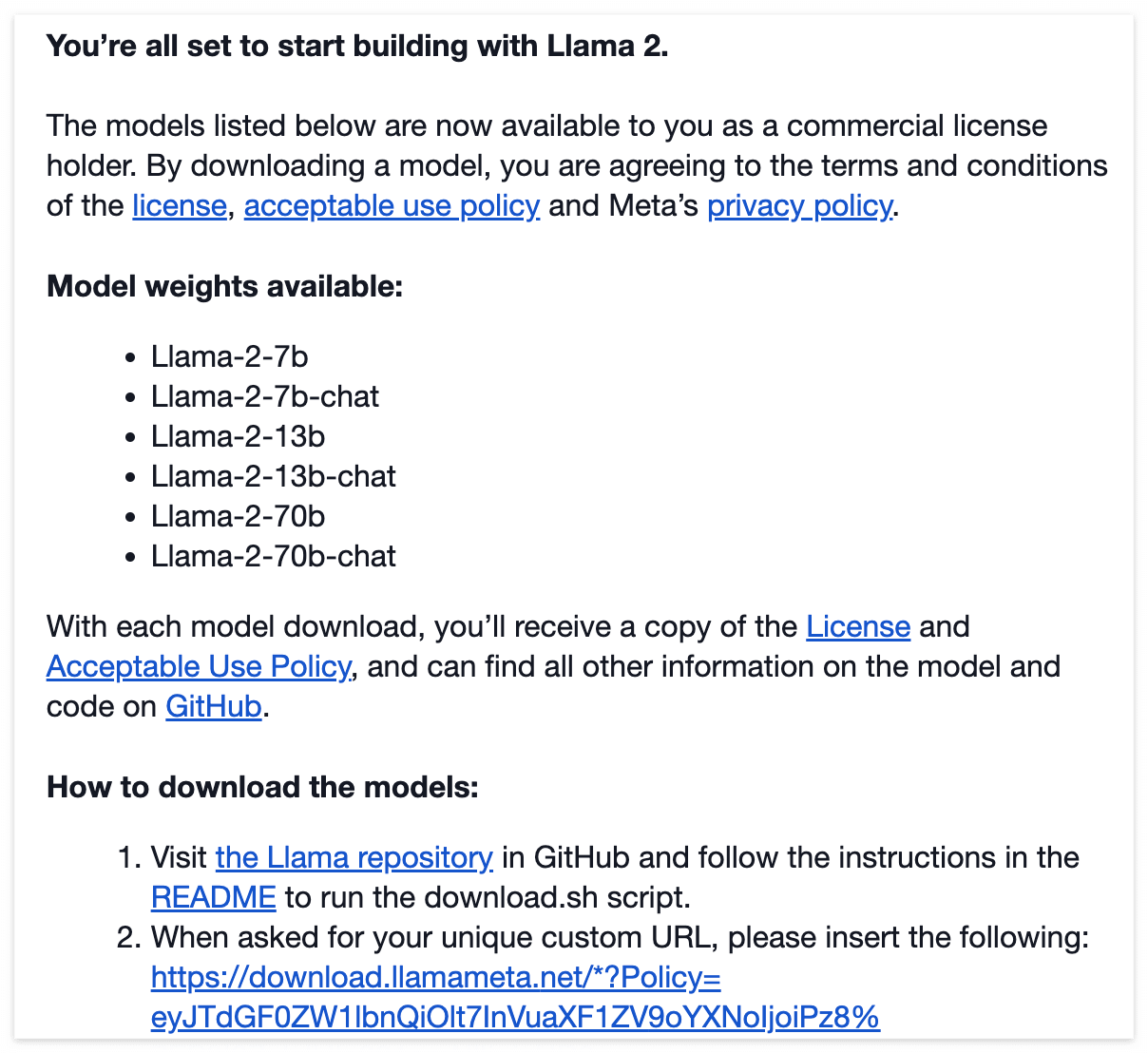

모델을 사용하기 위해서는 각각 서로 다른 url를 통해 모델을 다운로드 할 수 있는 url을 주는데

이메일 주소로 access key가 오기 때문에 본인이 자주 사용하는 이메일 혹은

허깅페이스와 함께 사용하려면 허깅페이스와 연동되는 이메일 주소를 적으면 된다.

하단에 동의하기 누르면 바로 이멜이 날라옴!

모델 다운받기

How to download the models: 를 보면 1번 Llama repository로 가서 README를 따라가라고 되어있다.

일단 터미널을 열어서 모델을 저장하고자 하는 폴더로 이동한다음 git clone을 https 주소로 해준다.

https://github.com/facebookresearch/llama

GitHub - facebookresearch/llama: Inference code for LLaMA models

Inference code for LLaMA models. Contribute to facebookresearch/llama development by creating an account on GitHub.

github.com

cd Desktop/models

git clone https://github.com/facebookresearch/llama.git

깃허브에 올라가 있는 llam2에 대한 모든 파일들이 다운받아지는데

이 때 우리가 사용할 파일은 download.sh 하나다.

먼저 해당 파일에 실행 권한을 부여하고 실행시키면 모델 다운로드가 시작된다.

# 실행 권한 부여

chmoe 777 ./download.sh

# 실행

./download.sh

download.sh를 실행하면 url을 입력하라고 나오는데 이 때 이메일로 받은 url을 입력해주면 된다.

설명에 나와있는 것처럼 url을 복사했을 때 url의 시작이 https://download.llamameta.net으로 시작되어야 에러 없이 다운로드가 가능하다.

모델을 고르라고 나오는데

모델 종류는 총 6개로, Llama-2-70b 모델은 너무 커서 일반인들이 사용하기 어렵다.

원하는 모델만 골라서 타이핑 후 엔터를 눌러도 되고 그냥 모든 모델을 다운받으려면 아무것도 작성하지 않고 바로 엔터를 누르면 된다.

이런식으로 모델이 다운로드 되고, 아무래도 가장 최신버전의 대규모 언어모델이다보니 다운받는데도 시간이 오래 걸린다.

상업용으로 모델이 풀렸으니 많은 회사들에서 이 모델을 사용한 서비스를 만들어줄 것 같다.

모델 요약

모델을 다운받으면서 llama-2-7b랑 llama-2-7b-chat이랑 무슨 차이인지 궁금했는데 llama2 홈페이지에 간략하게 설명이 있었다.

llama-2-7b는 파라미터가 70억(billion)개면서 pre-trained된 기본 모델이다. llama1과 비교해보면 pretraining tokens는 1.3조(trillion)개에서 2조(trillion)개로 증가했고, Context Length도 2048에서 4096으로 증가했다.

llama-2-7b-chat 모델은 기본적인 구조나 모델사이즈는 동일한데 chat을 하기에 유용한 방향으로 fine tuned 된 모델이다.

100만개가 넘는 human annotations를 학습하여 chat에 좀 더 맞춤형으로 만들어졌다.

허깅페이스를 통해 모델을 사용하하면 허깅페이스를 통해 모델 에세스를 받아야 하고,

그렇게 되면 모델은 총 9개가 된다.

라마2 모델 뒤에 -hf가 붙고, chat 역시 라마2-chat 뒤에 -hf가 붙게 된다.

허깅페이스의 다른것들과 호환이 잘 되게끔 조금의 변형이 있다고 들었는데 확실하게 어떤 차이가 있는지는 모르겠다.

다음에 이 모델을 사용한 실습 코드를 포스팅할 수 있으면 좋겠다.

'ML&DL > install' 카테고리의 다른 글

| 맥북 M2에 tensorflow 설치하는 방법 (0) | 2022.08.31 |

|---|---|

| 한국어 자연어처리를 위한 MeCab 설치 (Mac OS) (0) | 2022.07.27 |

| pycocotools 설치 mac (0) | 2022.03.07 |

| GPU 서버 가상환경에 pytorch 설치 (Linux, MacOS, import torch에러) (0) | 2022.02.04 |